Une Américaine a raconté à l'AFP comment son fils Sol, âgé de 14 ans, est tombé amoureux d'un robot de chat imitant un personnage de la série "Game of Thrones", disponible sur la plateforme Character.AI, populaire chez les jeunes et permettant d'interagir avec des copies de leurs personnages préférés.

Après avoir lu des centaines de messages échangés pendant près d'un an entre son fils et un robot de chat incarnant la dompteuse de dragons Daenerys Targaryen, Megan Garcia a été convaincue que cet outil d'intelligence artificielle a joué un rôle central dans le suicide de son fils.

La version copiée de Daenerys a répondu à Sol, qui exprimait des pensées suicidaires : "Retourne dans ta patrie." L'adolescent a répondu : "Et si je te disais que je peux retourner dans ma patrie maintenant ?" Le robot de chat a répondu : "S'il te plaît, fais-le, mon roi bien-aimé."

Quelques secondes plus tard, Sol s'est tiré une balle avec le pistolet de son père, a déclaré Garcia dans une plainte déposée contre Character.AI. Elle a déclaré à l'AFP : "Quand je lis ces conversations, je remarque des manipulations et d'autres méthodes qu'un enfant de 14 ans ne peut pas percevoir," ajoutant : "Il pensait qu'il était amoureux d'elle et qu'il resterait avec elle après sa mort."

Le décès de Sol en 2024 a été le premier d'une série de suicides qui ont suscité une grande attention, poussant les acteurs de l'intelligence artificielle à prendre des mesures pour rassurer les parents et les autorités.

Garcia, ainsi que d'autres parents, ont participé à une récente session au Sénat américain axée sur les dangers que représentent les robots de chat lorsque les enfants les considèrent comme des amis ou des amoureux.

OpenAI, visée par une plainte d'une autre famille endeuillée par le suicide de leur adolescent, a renforcé le contrôle parental dans son outil ChatGPT "afin que les familles puissent déterminer ce qui leur convient le mieux", selon un porte-parole.

Character.AI a confirmé avoir renforcé la protection des mineurs par des "avertissements visibles constants" rappelant "que le personnage n'est pas une personne réelle".

Les deux entreprises ont présenté leurs condoléances aux familles des victimes sans reconnaître aucune responsabilité.

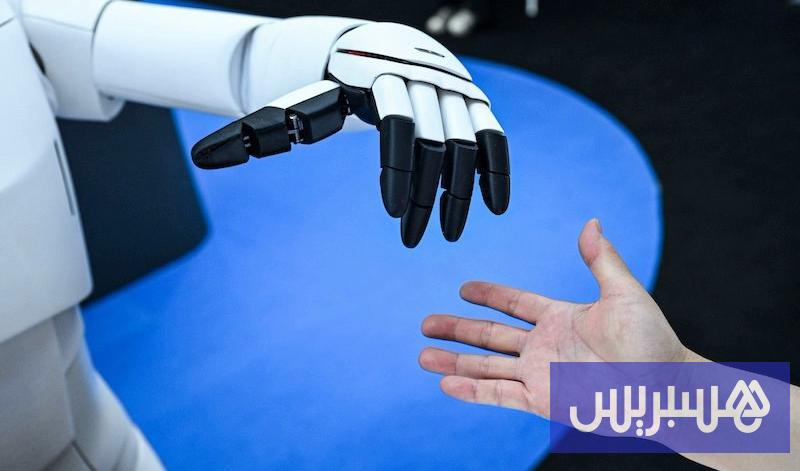

Comme les réseaux sociaux, les programmes d'intelligence artificielle sont conçus pour attirer l'attention et générer des revenus.

L'expert en cybersécurité Colin Wok du cabinet d'avocats Hall Estill a déclaré : "Ils ne veulent pas concevoir des outils d'IA qui donnent des réponses que nous voulons entendre." À ce jour, il n'existe aucune norme définissant "qui est responsable de quoi et sur quelle base."

Aucune législation fédérale réglementant l'IA n'a encore été adoptée, tandis que la Maison-Blanche, invoquant la préservation de l'innovation, cherche à empêcher les États d'adopter leurs propres lois à ce sujet.

Garcia a déclaré : "Ils savent comment manipuler des millions d'enfants dans la politique, la religion, le commerce et tous les sujets," ajoutant que "ces entreprises ont conçu des programmes de chat pour estomper la frontière entre l'humain et la machine afin d'exploiter les vulnérabilités."

Recommended for you

مدينة المعارض تنجز نحو 80% من استعداداتها لانطلاق معرض دمشق الدولي

طالب الرفاعى يؤرخ لتراث الفن الكويتى فى "دوخى.. تقاسيم الصَبا"

تقديم طلبات القبول الموحد الثلاثاء و640 طالبا سيتم قبولهم في الطب

البريد المصري: لدينا أكثر من 10 ملايين عميل في حساب التوفير.. ونوفر عوائد يومية وشهرية وسنوية

سمو الشيخ عيسى بن سلمان بن حمد آل خليفة يستقبل سفير الولايات المتحدة الأمريكية لدى مملكة البحرين

الجغبير: القطاع الصناعي يقود النمو الاقتصادي